Apple anunció en un boletín de prensa sobre las nuevas funciones de accesibilidad que llegarán a finales de este año, incluyendo Eye Tracking, una forma para que los usuarios con discapacidades físicas controlen el iPad o el iPhone con sus ojos.

Algo más: Music Haptics ofrecerá una nueva manera para que los usuarios sordos o con dificultades auditivas experimenten la música utilizando Musica permitirá a los usuarios realizar tareas haciendo un sonido personalizado; Vehicle Motion Cues puede ayudar a reducir el mareo por movimiento al usar el iPhone o iPad en un vehículo en movimiento; y más funciones de accesibilidad llegarán a visionOS.

“Durante casi 40 años, Apple ha defendido el diseño inclusivo al incorporar la accesibilidad en el centro de nuestro hardware y software. Estamos continuamente superando los límites de la tecnología y estas nuevas características reflejan nuestro compromiso de larga data de brindar la mejor experiencia posible a todos nuestros usuarios”, comentó Tim Cook, director ejecutivo de Apple.

Estas características combinan el poder del hardware y el software de Apple, aprovechando el silicio de Apple, la inteligencia artificial y el aprendizaje automático para reforzar el compromiso de décadas de Apple con el diseño de productos para todos.

“Creemos profundamente en el poder transformador de la innovación para enriquecer vidas”, dijo Tim Cook, CEO de Apple.

Por eso, durante casi 40 años, Apple ha defendido el diseño inclusivo al integrar la accesibilidad en el núcleo de nuestro hardware y software.

Continuamente estamos empujando los límites de la tecnología, y estas nuevas funciones reflejan nuestro compromiso de larga data con ofrecer la mejor experiencia posible a todos nuestros usuarios.

“Cada año, rompemos nuevas barreras en cuanto a accesibilidad,” dijo Sarah Herrlinger, directora sénior de Política e Iniciativas Globales de Accesibilidad de Apple.

“Estas nuevas funciones tendrán un impacto en la vida de una amplia gama de usuarios, proporcionando nuevas formas de comunicarse, controlar sus dispositivos y moverse por el mundo.”

Eye Tracking llega al iPad y al iPhone

Impulsado por inteligencia artificial, Eye Tracking ofrece a los usuarios una opción integrada para navegar por el iPad y el iPhone solo con sus ojos.

Diseñado para usuarios con discapacidades físicas, Eye Tracking utiliza la cámara frontal para configurarse y calibrarse en segundos, y con el aprendizaje automático en el dispositivo, todos los datos utilizados para configurar y controlar esta función se mantienen de manera segura en el dispositivo y no se comparten con Apple.

Eye Tracking funciona en todas las aplicaciones de iPadOS y iOS, y no requiere hardware adicional ni accesorios.

Con Eye Tracking, los usuarios pueden navegar por los elementos de una aplicación y usar Dwell Control para activar cada elemento, accediendo a funciones adicionales como botones físicos, deslizamientos y otros gestos solo con sus ojos.

Music Haptics hace que las canciones sean más accesibles

Music Haptics es una nueva forma para que los usuarios sordos o con dificultades auditivas experimenten la música en el iPhone.

Con esta función de accesibilidad activada, el Taptic Engine en el iPhone reproduce toques, texturas y vibraciones refinadas al ritmo del audio de la música.

Music Haptics funciona en millones de canciones del catálogo de Apple Music y estará disponible como una API para que los desarrolladores hagan la música más accesible en sus aplicaciones.

Nuevas funciones para una amplia gama de habla

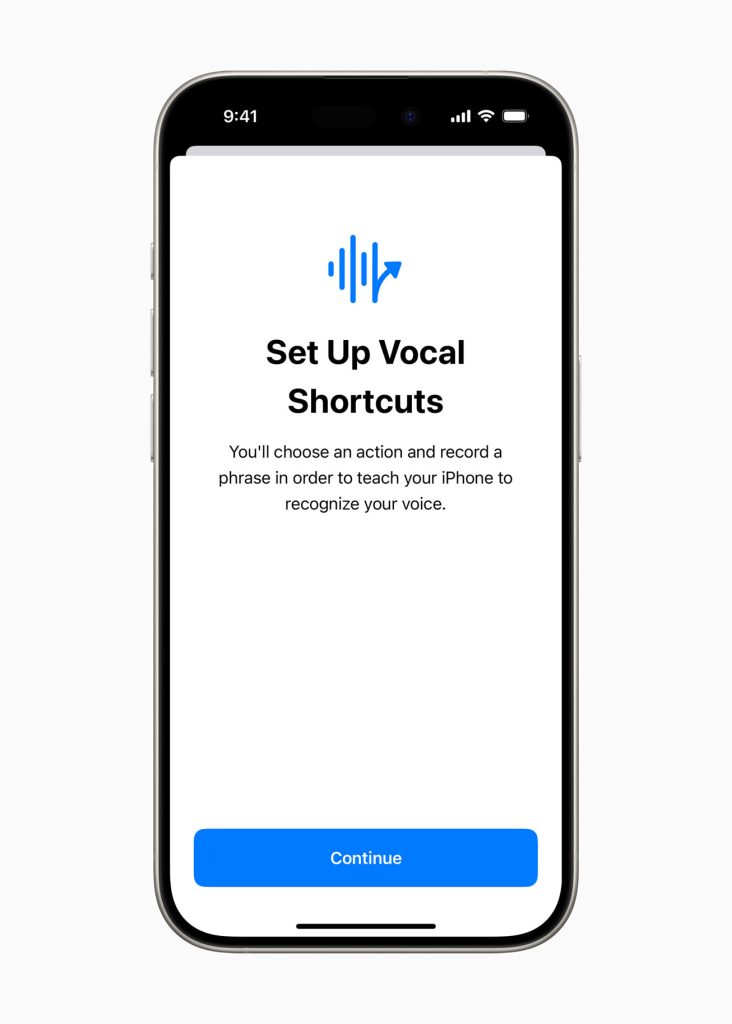

Con Vocal Shortcuts, los usuarios de iPhone y iPad pueden asignar expresiones personalizadas que Siri puede entender para iniciar atajos y completar tareas complejas.

Listen for Atypical Speech, otra nueva función, ofrece a los usuarios una opción para mejorar el reconocimiento del habla en una gama más amplia de patrones de habla.

Listen for Atypical Speech utiliza el aprendizaje automático en el dispositivo para reconocer los patrones de habla del usuario.

Diseñadas para usuarios con condiciones adquiridas o progresivas que afectan el habla, como la parálisis cerebral, la esclerosis lateral amiotrófica (ELA) o los accidentes cerebrovasculares, estas funciones proporcionan un nuevo nivel de personalización y control, basándose en las funciones introducidas en iOS 17 para usuarios que no hablan o que están en riesgo de perder su capacidad de hablar.

La inteligencia artificial tiene el potencial de mejorar el reconocimiento del habla para millones de personas con habla atípica, por lo que estamos encantados de que Apple esté llevando estas nuevas funciones de accesibilidad a los consumidores,” dijo Mark Hasegawa-Johnson, investigador principal del Speech Accessibility Project en el Beckman Institute for Advanced Science and Technology de la Universidad de Illinois en Urbana-Champaign.

“El Speech Accessibility Project fue diseñado como un esfuerzo amplio y apoyado por la comunidad para ayudar a las empresas y universidades a hacer que el reconocimiento del habla sea más robusto y efectivo, y Apple está entre los defensores de la accesibilidad que hicieron posible el Speech Accessibility Project.”

Vehicle Motion Cues puede ayudar a reducir el mareo por movimiento

Vehicle Motion Cues es una nueva experiencia para iPhone y iPad que puede ayudar a reducir el mareo por movimiento en los pasajeros de vehículos en movimiento.

Las investigaciones muestran que el mareo por movimiento es comúnmente causado por un conflicto sensorial entre lo que una persona ve y lo que siente, lo que puede impedir que algunos usuarios usen cómodamente el iPhone o el iPad mientras viajan en un vehículo en movimiento.

Con Vehicle Motion Cues, puntos animados en los bordes de la pantalla representan los cambios en el movimiento del vehículo para ayudar a reducir el conflicto sensorial sin interferir con el contenido principal.

Utilizando los sensores integrados en el iPhone y el iPad, Vehicle Motion Cues reconoce cuando un usuario está en un vehículo en movimiento y responde en consecuencia.

La función se puede configurar para que se muestre automáticamente en el iPhone o se puede activar y desactivar en el Centro de Control.

Actualizaciones adicionales

Para los usuarios ciegos o con baja visión, VoiceOver incluirá nuevas voces, un rotor de voz flexible, control de volumen personalizado y la capacidad de personalizar los atajos de teclado de VoiceOver en Mac. Magnifier ofrecerá un nuevo Modo de Lectura y la opción de iniciar fácilmente el Modo de Detección con el botón de Acción.

Los usuarios de braille tendrán una nueva forma de iniciar y mantenerse en la Entrada de Pantalla en Braille para un control y edición de texto más rápidos; disponibilidad del idioma japonés para la Entrada de Pantalla en Braille; soporte para braille de múltiples líneas con Dot Pad; y la opción de elegir diferentes tablas de entrada y salida. Para los usuarios con baja visión, Hover Typing muestra texto más grande al escribir en un campo de texto, y en la fuente y color preferidos del usuario.

Para los usuarios en riesgo de perder su capacidad de hablar, Personal Voice estará disponible en mandarín chino. Los usuarios que tienen dificultades para pronunciar o leer oraciones completas podrán crear una Voz Personal usando frases abreviadas. Para los usuarios que no hablan, Live Speech incluirá categorías y compatibilidad simultánea con Live Captions.

Para los usuarios con discapacidades físicas, Virtual Trackpad para AssistiveTouch permite a los usuarios controlar su dispositivo usando una pequeña región de la pantalla como un trackpad redimensionable.

Switch Control incluirá la opción de usar las cámaras en iPhone y iPad para reconocer gestos de toques con los dedos como interruptores. Voice Control ofrecerá soporte para vocabularios personalizados y palabras complejas.

TE PUEDE INTERESAR LEER: